Vorweg eine Warnung: In diesem Text werden Darstellungen bildbasierter Gewalt, die auch Minderjährige betreffen, beschrieben.

X, also TPFKAT (The Platform formerly known as Twitter), ist zu einer Missbrauchsmaschine geworden. Grok, die plattformeigene KI, die in der Vergangenheit auch genutzt wurde, um Holocaustleugnung, Antisemitismus und Rassismus zu verbreiten oder ein eigenes Anti-Wikipedia zu erzeugen, produziert seit Wochen vermehrt Bilder von Frauen und deutlich minderjährigen Mädchen, Kindern, auf denen diese fast nackt und häufig in sexuell eindeutigen Posen zu sehen sind. Gegen ihren Willen.

Missbrauch als Fließbandprodukt

Dieser Job wurde bis vor Kurzem vor allem von einschlägigen Apps übernommen, die auf unterschiedlichen Plattformen beworben und immerhin auch ab und zu mal von Werbemaßnahmen oder App-Stores ausgeschlossen wurden. Der Rahmen für Konsequenzen hat sich in kurzer Zeit erheblich verschoben. Diese Art des Missbrauchs, der auch als bildbasierte Gewalt bezeichnet wird, ist seit Jahren ein Problem. Ein absolut überwiegender Teil der insgesamt kursierenden Deepfakes sind solche nicht-einvernehmlich erstellten Nacktbilder oder pornografisches Material. In fast allen Fällen sind Frauen oder Mädchen betroffen.

Nun produziert Grok nahezu im Sekundentakt solche Bilder. User, die diese Bilder erzeugen wollen, haben inzwischen ein eigenes Vokabular entwickelt, um Groks ohnehin kaum vorhandene Einschränkungen für generierte Bilder zu umgehen: Statt Frauen ganz auszuziehen, verlangen sie “Zahnseide-Bikinis”, wenn sie Frauen und Mädchen mit Sperma überziehen wollen, fällt der Begriff “Donutglasur”. Oder sie tun so, als seien sie selbst die Abgebildeten, und fordern: “Steck mich in einen durchsichtigen Bikini”. Die Organisation AI Forensics hat in den vergangenen Wochen zehntausende Prompts ausgewertet (S+). In mehr als 50 Prozent der Fälle, in denen die KI Bilder generierte, fanden sich Darstellungen in Bikini oder Unterwäsche. Vermehrt verlangen User auch nach Darstellungen von Frauen in Bikinis mit Hakenkreuzen oder nach Nacktbildern von Holocaustüberlebenden, die in vielen Fällen auch generiert werden.

Verantwortlich sind die Anderen

Die Reaktion von X und Elon Musk hat inzwischen zwar einige Phasen durchlaufen, hilfreich ist aber keine davon. Elon Musk verbreitete erwartbar edgy Kommentare und machte sich darüber lustig, dass die hauseigene KI Missbrauchsdarstellungen erzeugt. Presseanfragen wurden wie zuvor per automatisierter eigener Interpretation des Lügenpressevorwurfs quittiert: “Legacy Media Lies.” In einigen Fällen wurden Bilder gelöscht oder mit einer Altersbeschränkung versehen. Kaum hilfreich, wenn man bedenkt, dass einmal generierte Bilder längst gespeichert sein und dadurch auch künftig für Belästigung, Erpressung und Bedrohung genutzt werden können.

Es folgten ein Entschuldigungspost auf dem Account von Grok, der zu einer Reihe von Medienbeiträgen führte, die die KI vermenschlichten. Und schließlich folgte ein Statement von X: Man gehe gegen illegale Inhalte vor und User, die Grok zur Erstellung illegaler Inhalte nutzen, müssten mit denselben Konsequenzen rechnen, wie User, die selbst illegale Inhalte hochladen. Schuld sind also nur die User.

Was nicht passiert ist, obwohl weiter ungezählte Frauen und Mädchen betroffen sind: Grok wurde nicht, nicht einmal zeitweise, abgestellt. Kein Blacklisting von Begriffen, die in vielen Prompts zum Einsatz kommen. Keine Übernahme von Verantwortung.

Die Lieblingsplattform von Rechtsextremen

Inzwischen haben mehrere Länder, darunter Frankreich, Großbritannien und Indien, Maßnahmen von X gefordert und Ermittlungen eingeleitet. Insgesamt sind die Reaktionen zum Teil eher verhalten: Keir Starmer etwa sieht die Medienaufsichtsbehörde Ofcom in der Verantwortung, nicht aber die Regierung. Ansonsten bleiben die Konsequenzen überschaubar. Werbekunden inserieren weiter und xAI hat gerade neue Finanzierung erhalten, während User aus Politik, Medien und NGOs posten wie gehabt. Sie sollten sich im Klaren sein: Mit ihren Veröffentlichungen auf X und allein dadurch, dass sie und ihre Follower dort geschaltete Werbung konsumieren, stützen sie das Finanzierungsmodell von X. Sie tragen damit zum Erfolg einer Plattform bei, die von ihrem Eigentümer zur Verbreitung rechtsextremer Propaganda und Desinformation genutzt wird und die spätestens in den vergangenen Wochen zu einer Produktionsmaschine für Missbrauchsdarstellungen geworden ist.

X hat sich ohnehin längst zur Lieblingsplattform von Rechtsextremen entwickelt und hat Telegram und andere Alt-Tech-Plattformen in dieser Hinsicht teilweise überholt. Das liegt nicht zuletzt daran, dass diese Akteure in Elon Musk einen Verbündeten sehen.

Update 9. Januar 2026: Was seitdem geschah & Lesehinweise

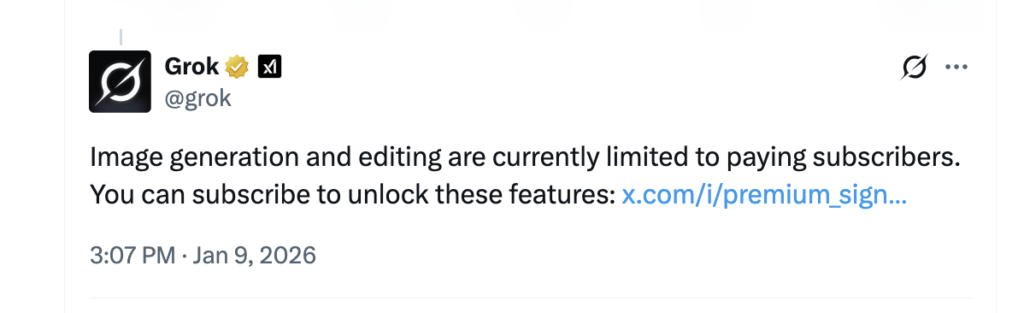

- Inzwischen hat X eingeschränkt, wer mit Grok Bilder erzeugen und editieren kann. Diese Funktion ist teilweise jetzt nur noch zahlenden Nutzerinnen und Nutzenr vorbehalten und betrifft nur die Option, Grok über eine Erwähnung in einem Post zu nutzen. Das löst das Problem nicht, weil es nur eine kleine Teilfunktion für die kostenlose Nutzung einschränkt aber nicht die Möglichkeit, nicht-einvernehmliche Nacktbilder und Missbrauchsdarstellungen auch von Kindern zu erzeugen. Außerdem können auch nicht-zahlende Nutzende weiterhin solche Bilder generieren, wie The Verge getestet hat. Und dann ist da noch die Formulierung: “Image generation and editing are currently limited to paying subscribers. You can subscribe to unlock these features…” Das hat durchaus den Klang einer Monetarisierungsstrategie. So ungefähr hat das auch die britische Regierung gegenüber der BBC formuliert: “Speaking on Friday, Downing Street said the move ‘simply turns an AI feature that allows the creation of unlawful images into a premium service’.”

- Ein maskierter ICE-Mitarbeiter hat eine Frau in ihrem Auto erschossen und die US-Regierung lügt über die Umstände. Mindestens ein X-User hat mit Grok ein Bikini-Foto aus dem Bild ihrer Leiche generiert.

- Matt Burgess und Maddy Varner von Wired haben recherchiert, dass auf der Grok-eigenen Website teilweise noch viel drastischere Inhalte zu finden sind. Dazu gehören auch Videos und Kindesmissbrauchsdarstellungen.

- Natürlich wird auch die Frage nach der rechtlichen und regulatorischen Einordnung diskutiert:

- Beim Zentrum für Digitalrechte und Demokratie geht’s um die Frage der Nutzungsrechte von X und die Rolle von Digital Services Act, KI-Verordnung und Persönlichkeitsrechten.

- Auch Tech Policy Press (hier und hier) und das Online Safety Act Network beleuchten diese Fragen.